关键词:麻将AI,Suphx,卷积神经网络

2019年8月29日,微软发布了一个名为Suphx(超级凤凰)的「麻将AI」,在专业的麻将竞技平台上,Suphx的实力胜过了顶级人类选手的平均水平。

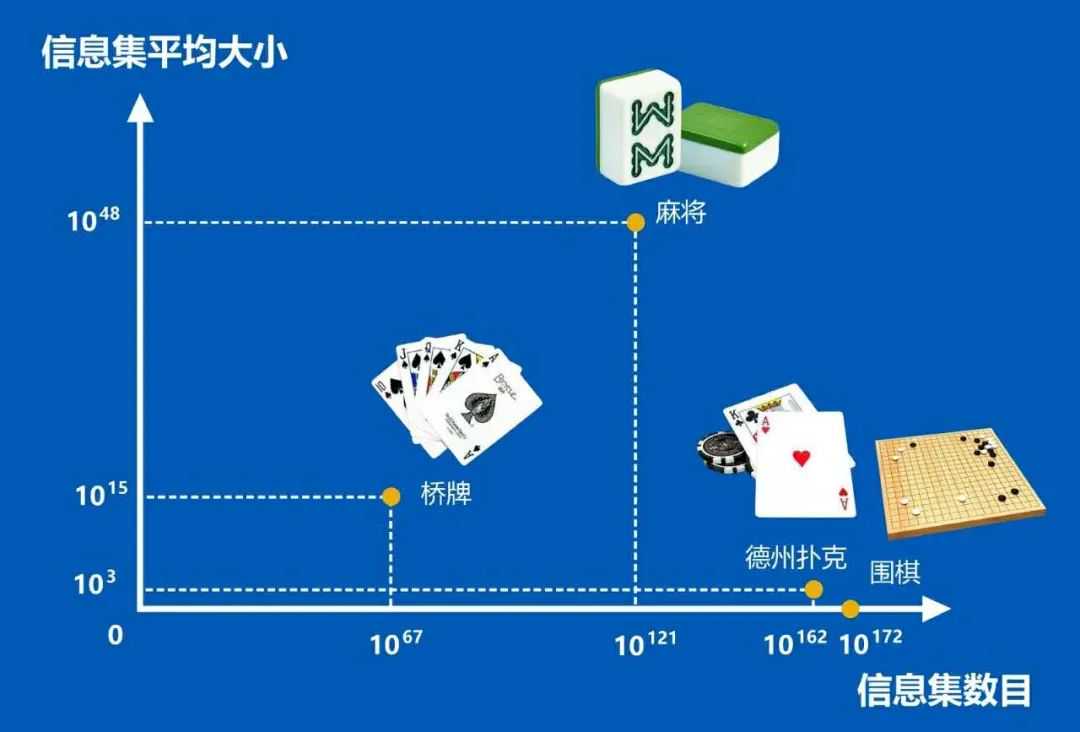

麻将的信息集数目和信息集平均大小超过了桥牌、德扑和围棋

人们评价该系统比战胜了职业围棋手的AlphaGo更复杂,被誉为「最强日麻人工智能」。

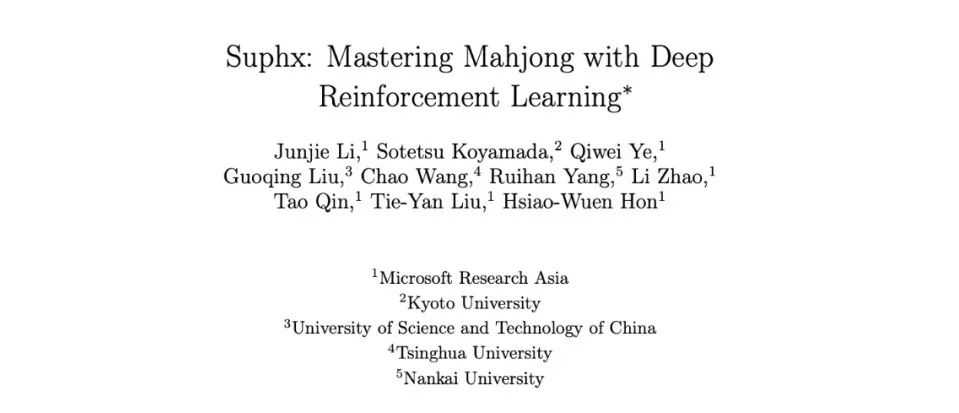

今天,该系统的研发团队在arXiv上发表了论文《Suphx:MasteringMahjongwithDeepReinforcementLearning》(《Suphx:掌握麻将与深度强化学习》),更深一步地讲解了Suphx背后的技术。

《Suphx:掌握麻将与深度强化学习》

论文地址:

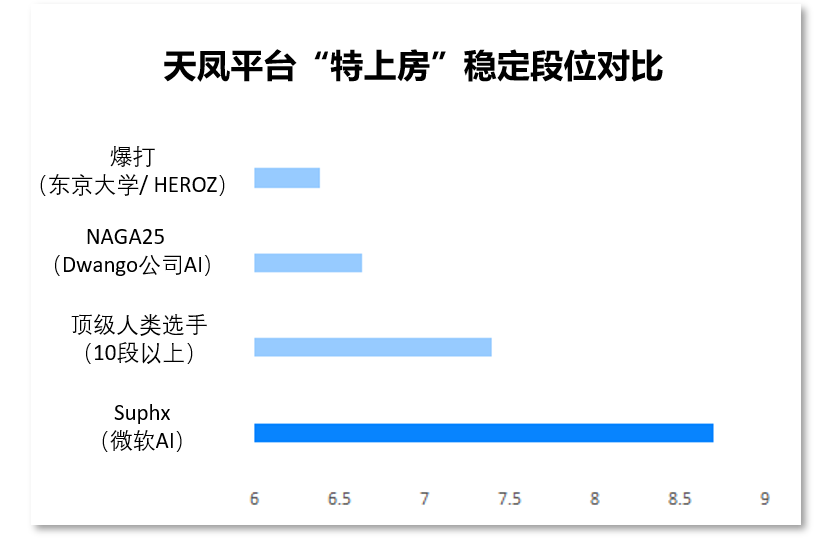

Suphx愈战愈勇:已超越99.99%玩家此前我们已经介绍过,Suphx系统利用深度强化学习,从5000场比赛中学习、吸取经验之后,在日本专业的麻将竞技平台「天凤」上击败了众多麻将玩家,取得平台「特上房」的最高段位十段。

Suphx在天凤平台的段位,远高于其它麻将AI

这样一个强悍的麻将AI,究竟是如何打造的?来自微软亚洲研究院、京都大学、中国科学技术大学、清华大学以及南开大学的研究团队,在最新版的论文中,进行了深入的介绍。

从论文中,我们也得知,Suphx在进一步的学习下,水平也更进一步。在拥有超过35万位玩家的「天凤」平台上,被官方评为水平超越99.99%以上玩家,这是计算机程序首次超过麻将中大多数顶级人类玩家。

五大模型与强化学习,造就雀神AISuphx包含一系列卷积神经网络,它学习了五种模型来处理不同的场景,包括discard(丢弃模型)、Riichi模型、chow模型、Pong模型和Kong模型。

discard模型(上)与其它四个模型的架构(下)

在此基础上,Suphx采用另一种基于规则的模型,来决定是否宣布赢家并进行下一轮,检查是否赢牌可以从其他玩家丢弃的牌中来判断,或者从排墙上抽出来的牌来判断。

据介绍,Suphx的训练过程一共分为三步。

首先,它的5个模型都使用从「天凤」平台收集的顶级人类玩家的日志进行训练。

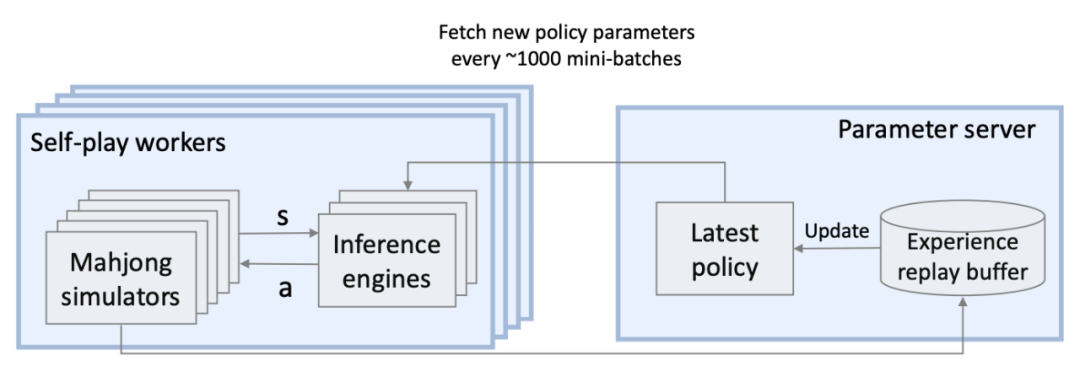

然后,使用包含一套基于CPU的麻将模拟器和基于GPU的轨迹生成推理引擎,通过自我博弈强化学习对系统进行微调。

最后,在在线游戏期间,使用运行时策略调整被用来观察当前轮的结果,从而使系统执行得更好。

Suphx中的分布式强化学习系统

由于麻将牌局中,对手的信息都是未知的,因此,Suphx尝试了先知教练技术来提升强化学习的效果。在自我博弈的训练阶段,利用隐藏信息引导模型训练方向,从而增强AI模型对可见信息的理解,并找到有效的决策依据。

评估:5760场角逐,创造十段纪录在实验之前,团队在44个GPU(包括4个NvidiaTitanXPs用于参数服务器,40个K80s用于自我博弈玩家)上,使用150万次牌局,对每个模型进行了为期两天的训练。

该团队对20个NvidiaTeslaK80GPU上的Suphx进行了评估。为了减小稳定排名的方差,他们从100多万场的麻将牌局数据集中,随机抽取了80万牌局的数据,并从中进行了1000次取样。

评估结果为,在「天凤」平台与人类玩家进行了超过5760场比赛后,Suphx创造了十段的纪录——大约只有180个玩家曾经达到过这个水平。而Suphx稳定的排名是8.74段(人类玩家最高水平是7.4段)。

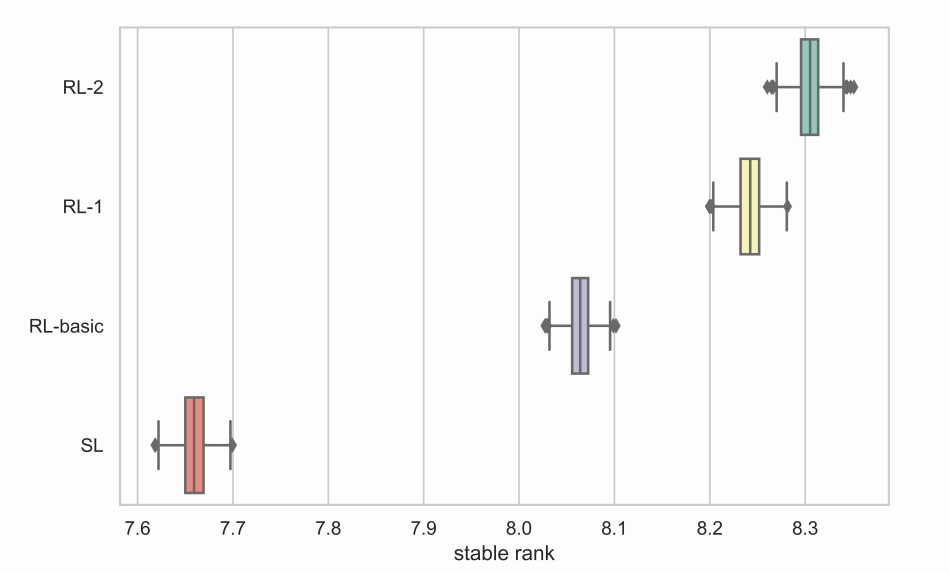

强化学习agent最终稳定排名统计在不断优化中,RL-2最终取得更好的表现

有趣的是,研究人员写道,Suphx的防守「非常强」,放胡的概率很低,只有10.06%,而且它开发了自己的游戏风格,可以保证牌的安全,并以半平手取胜。

AI玩家(南方)会选择保守打法,放弃篮筐内的六筒,因为牌桌上已有该牌

此外,论文的合著者写道,大多数现实世界的问题,如金融市场预测和物流优化与麻将有相同的特点。比如复杂的操作/奖励规则、非完美信息问题等等。

作者相信,在Suphx中设计的麻将技术,包括全局奖励预测、先知引导以及政策调整等,都有巨大的潜力,将来可广泛应用于现实世界,帮助解决真实而复杂的实际问题。